Großer Bahnhof auf dem diesjährigen Kundentag „QUNIS Day“ in Neubeuern. Mit neuem Besucherrekord und aufgeräumter Stimmung ging es am Morgen in die Konferenz, in deren Mittelpunkt Best Practices für Business Intelligence, Big Data und Advanced Analytics sowie der fachliche Austausch stehen. Unter dem Motto „Innovation Now“ erläutern Senior Analysten sowie unsere Kunden Henkel und Südpack wie sich die allgegenwärtige digitale Transformation der Unternehmen aktuell darstellt.

Großes Anwendertreffen zu Business Intelligence, Big Data und Advanced Analytics auf dem QUNIS Day 2017. Quelle: QUNIS

Geschäftsführer Hermann Hebben konnte zum Auftakt das erfolgreichste Geschäftsjahr seit Firmengründung 2013 verkünden. Mittlerweile werden über 150 Unternehmen im Mittelstand und Konzern betreut und auch die Belegschaft sei in den letzten zwölf Monaten um 73% gewachsen. Auch wirtschaftlich stehe das Beratungshaus sehr gut dar. Hebben betonte aber, dass man weiterhin auf die Kernkompetenz setzen werde, statt neue Beratungsfelder um jeden Preis anzugehen: „G´scheid oder gar ned!“.

Data Warehouse schneller und performant aufbauen

In den letzten zwölf Monaten wurden viele erfolgreiche Projekte umgesetzt. Die Strategieberatung bleibt dabei von zentraler Bedeutung, um ein Fundament für erfolgreiche Initiativen zu legen. Mit Blick auf die Umsetzung von Anforderungen hat QUNIS sein im Markt einmaliges „Data Warehouse Framework“ weiterentwickelt und in vielen Data-Warehouse-Projekten eingesetzt. Ferner wird auf dem QUNIS Day mit der „QUNIS Automation Engine“ erstmals im Plenum eine neue Methode und Technik vorgestellt, mit der sich die Beladung eines Data-Warehouse-“Core“ automatisieren lässt. Gut entwickle sich laut Hebben auch die Schwesterfirma GAPTEQ, die sich nach ihrem Start im September 2016 mittlerweile gut im Markt etabliert hat.

Digitalisierung verändert das Datenmanagement und Datenanalyse

All diese Entwicklungen erfolgen wie erwähnt in einem Marktumfeld, das sich für Unternehmen durch die Digitalisierung aktuell radikal verändert. Beispielhaft stellte Geschäftsführer Steffen Vierkorn vier Megatrends vor, die mit der Digitalisierung verknüpfte sind: Globalisierung, Mobilität, Konnektivität und Individualisierung. Die Technologie werde immer mehr zum Treiber von Veränderungen. Besonders sei dies bei der Nutzung von Cloud-Diensten und Komponenten wie „Microsoft Azure“ zu beobachten sowie bei der Vernetzung von Geräten (Internet of Things). Jenseits der Vorstellungskraft lägen mittlerweile die entstehenden Datenmengen. Bis 2025 sei mit 163 Zetabyte zu rechnen, so Vierkorn, die auf etwa 40 Billionen DVDs Platz hätten!

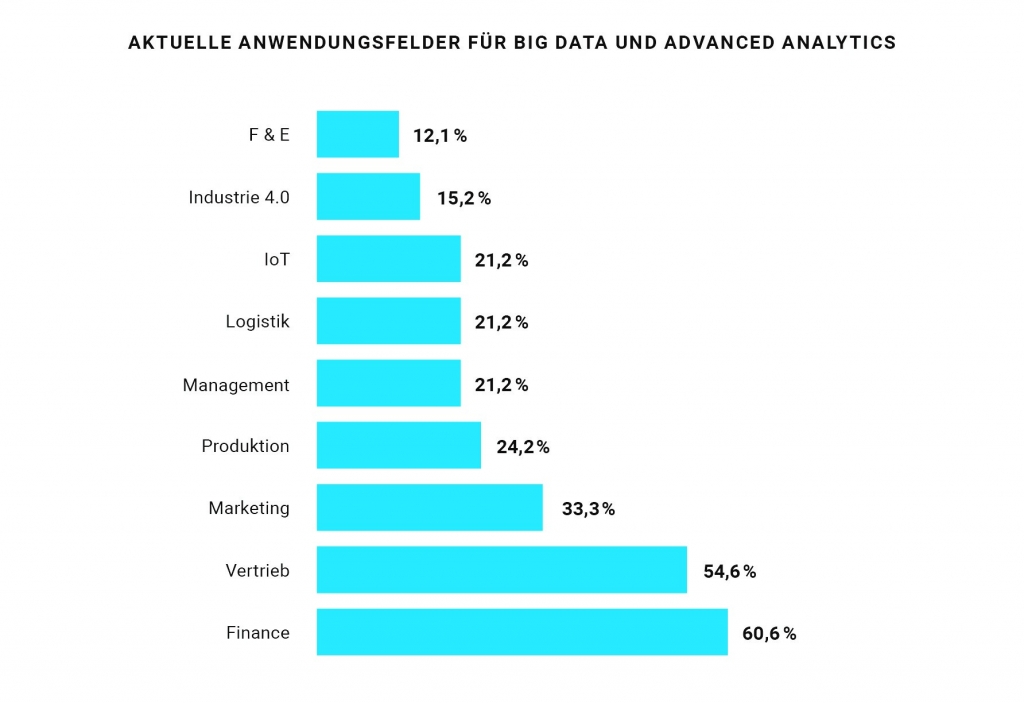

Veränderungen seien auch mit Hinblick auf die Datennutzung und -analyse bei der Produktentwicklung und Geschäftsbeziehungen zu beobachten. Die Rolle von Business Intelligence. Big Data und Advanced Analytics nehme in diesem Szenario weiter zu. Viele Unternehmen versuchten aktuell die Analytik in den Griff zu bekommen. In diesem Zusammenhang stellte Vierkorn das Data-Lake-Konzept der QUNIS vor.

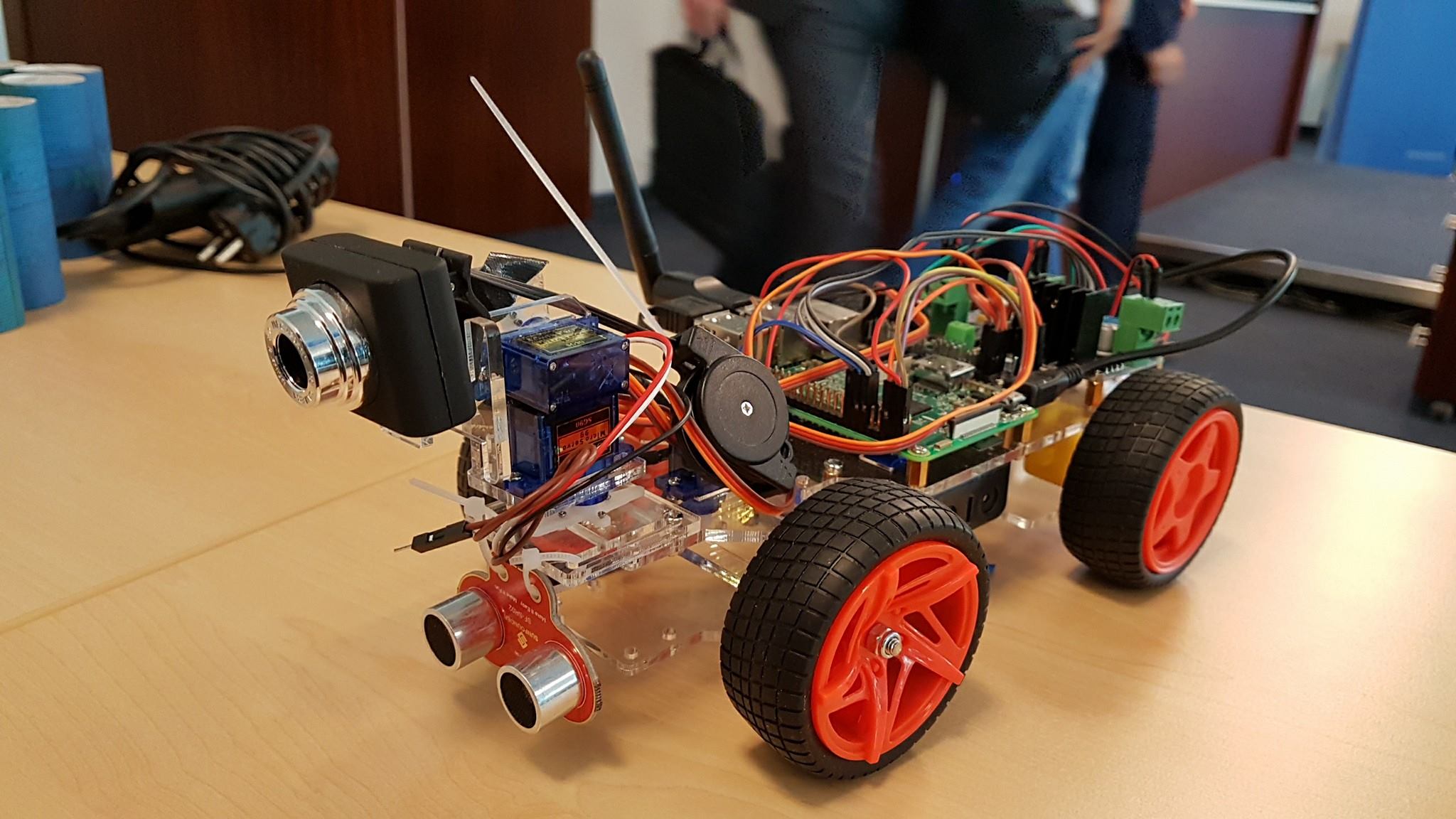

Ein Beispiel für die Nutzung Künstlicher Intelligenz war auf dem QUNIS Day am Beispiel eines Fahrzeugs zu sehen, das neben Gesichtserkennung auch Objekten beim Fahren ausweichen kann. Quelle: QUNIS

Die dazugehörige Architektur, die traditionelle Data-Warehouse-Welt und die Nutzung von Big Data methodisch und technologisch verknüpfen hilft, wurde auf der Veranstaltung ausführlich vorgestellt. Die Auswirkungen seien auch organisatorisch groß. So würde es künftig mehr und neue Rollen im Team geben müssen, um die unterschiedlichen Anforderungen abdecken zu können.

QUNIS Day 2017 Steffen Vierkorn und Patrick Eisner vom QUNIS-Management.