I. Voraussetzungen für den Business Value schaffen

Der Hype um BI ist abgeflacht, keiner stellt ihre Bedeutung mehr in Frage. Man weiß, die Technologien funktionieren. Die Unternehmen sind gerüstet, Budgets sind eingestellt. Genügend Erfahrungswerte und Best Practices sind vorhanden. Die große Herausforderung liegt jetzt darin, die vorhandenen Konzepte in Projekte zu gießen, die tatsächlich den größten und nachhaltigsten Nutzen stiften. Doch wo investiert man? Wie geht man vor? Was muss man beachten? Ein Patentrezept gibt es nicht. Was jedoch für alle Unternehmen gilt, es müssen die drei folgenden Fragen, und zwar besser gestern als heute, bearbeitet und geklärt werden:

Wer managt das Asset Daten? Als ersten und zentralsten Punkt gilt es zu defiinieren: Wer hat den Hut für die Daten und die analytischen Ergebnisse auf? Diese ist grundlegend und entscheidend, denn auswertungsrelevante Daten folgen häufig weder einem etablierten Unternehmensprozess noch der organisatorischen Linie. Vielmehr werden Daten cross-funktional erzeugt und an verschiedensten Stellen angereichert. Analytische Szenarien haben sehr häufig die Eigenschaft, diese Daten kombiniert auszuwerten.

Zudem gibt es im Gegensatz zu vielen traditionellen Bereichen wie der HR, die ein Talent- und Personal-Management kennt, oder dem Anlagenmanagement mit seinen Investitionsspiegeln und -plänen für die Datenwelt bis dato so gut wie keine, allenfalls rudimentäre Managementstrategien. Die Strukturen für unternehmensweites Datenmanagement und Analytics müssen daher in nahezu allen Unternehmen erst geschaffen werden. Und je nach Data-Driven-Business-Modell werden dabei Daten aus völlig verschiedenen Quellen, Bereichen und von unterschiedlichster Art benötigt.

Das alles unter eine Managementstrategie zu bringen, fordert also vor allem den Mut, vorhandene Organisationsstrukturen aufzubrechen. Denn, so hat sich gezeigt: Aus dem Boden gestampfte Sonderabteilungen sind nicht die Lösung! Vielmehr geht es darum, eine unternehmensübergreifende Datamanagementkultur zu schaffen und eine Organisationsform, die nicht aneckt und keine Flaschenhälse schafft. Immer mehr Unternehmen erkennen dies und setzen sich damit proaktiv auseinander.

Welchen Business Value bedient ein Use-Case? Der zweite wesentliche Aspekt auf dem Weg zum Business-Value liegt in der Betrachtung seiner selbst. Dabei geht es nicht um eine reine ROI-Berechnung, sondern um die Beantwortung der Frage, auf welchen betrieblichen Mehrwert die BI-, Big-Data- oder Analytics-Initiative einzahlen soll. Geht es beispielsweise darum, Prozesse besser zu analysieren, um damit Kosten zu sparen? Ist man auf mehr Umsatz oder bessere Qualität aus? Zielt die Initiative auf das Erreichen höherer Effizienz ab oder steht Risikominimierung im Vordergrund?

Wie werden Daten nachhaltig zugänglich gemacht? Der dritte nicht zu unterschätzende Punkt, den es bei BI und Analytics im Hinblick auf Nutzen und Value zu beachten gilt, ist das Thema Dokumentation. Gerade der Data Catalog erhält hier aufgrund der zunehmenden Komplexität und Heterogenität der Datenlandschaften als verlässlicher Wegweiser durch die Datenwelt eine wachsende Bedeutung. Um den Zugang zu Daten nachhaltig zu gewährleisten, müssen relevante Daten quellenübergreifend dokumentiert sein. Geeignete Data-Catalog-Tools sind am Markt gefragt und werden gesucht. Aber auch methodische Aspekte sind zu klären: Was soll drinstehen, wo findet man die relevanten Daten im Unternehmen und wer ist zuständig für die Datenqualität?

Auch wenn klassische Data-Warehousing-Konzepte im Sinne von Daten zusammenführen und harmonisieren weiterhin ihre Berechtigung behalten werden, ist ein Trend weg vom physischen Vorhalten aller Daten an einer zentralen Stelle bereits Realität. Der Weg geht hin zum Entwurf von Datenlandkarten, über die die Zugriffe realisiert werden. Das spart Zeit und Geld. Vor dem Hintergrund ständig wachsender Datenmengen entstehen so Datenarchitekturen, die den Geschwindigkeiten und Flexibilitätsanforderungen heutiger Geschäftsmodelle entsprechen. Es entstehen Data Landscapes und Data Oceans. Den Begriffsneuschöpfungen scheinen hier keine Grenzen und kein Ende gesetzt.

II. Cloud-Frontends setzen sich durch

Was in der Analytics-Welt am Backend schon eine Zeit lang gang und gäbe ist, gilt verstärkt nun auch für die Frontend-Welt: Moderne Cloud-basierte Frontends sind verfügbar und werden zunehmend diskussionsloser genutzt. Die Unternehmen scheinen ihre Skepsis und Furcht vor Cloud-Computing immer weiter abzulegen, gerade in unkritischeren Bereichen wie Vertrieb und Finance; allenfalls in sensibleren IP-nahen Bereichen mag das noch anders sein, etwa bei Rezepturen und Bauplänen. Die Öffnung hin zur Cloud ist dabei auf den generellen technologischen Fortschritt zurückzuführen, aber auch auf die naturgemäße „Ver-Rentung“ von Bedenkenträgern mit ihrer „alten Denke“ im Gepäck. So oder so ist der Trend hin zur Cloud nicht mehr zu stoppen: On-Premise-Systeme werden immer mehr zu Insellösungen.

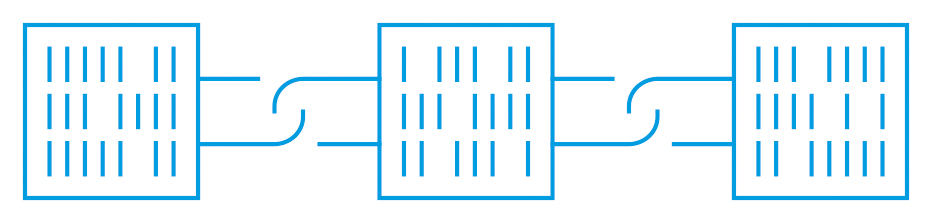

III. Query-Engines verbinden Welten

War es im letzten Jahr an gleicher Stelle noch reine Prognose, wird es jetzt zur Realität: Es gibt immer mehr Query- Engines am Markt, die strukturierte und unstrukturierte Datenwelten miteinander verbinden, ohne dass man hierfür Technologiewechsel in den Architekturen benötigt. Insofern wird es eine Orientierung auf nur eine Seite nicht mehr geben. Denn egal, was man an Quellen darunterpackt: Jegliche Formate lassen sich künftig über ein und denselben Dienst kombinieren und das unbegrenzt in beliebigem Ausmaß. Anbieter wie Azure Synapse Analytics verbinden Data Warehousing und Big Data. Dadurch wachsen die Welten im Sinne einer „Single Source of Truth for Enterprise Analytics” konzeptionell zusammen. Data Engineers, Data Scientisten und Analysten können so kollaborativ den gesamten Daten-Fundus abfragen, ohne dafür irgendwelche Daten bewegen zu müssen.

IV. Zusammenspiel von Data Science, Data Engineering und Data Governance bewusst fördern

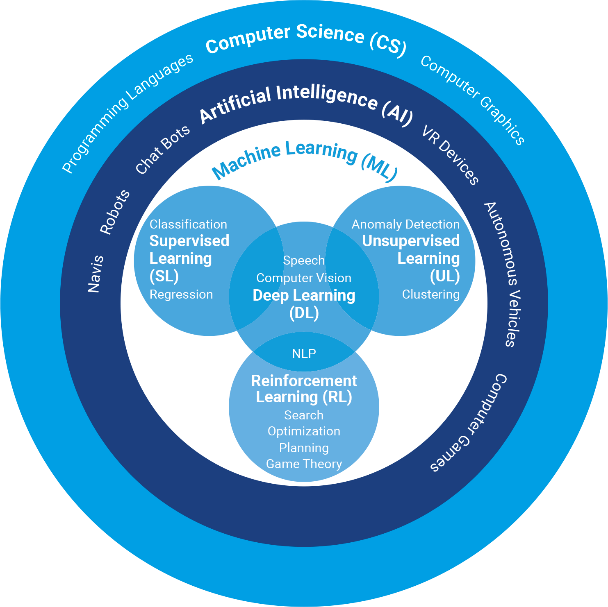

Apropos Data Scientist: Der bleibt auch weiterhin wichtig, muss aber zunehmend zu den Business Values beitragen, um seine Bedeutung und Daseinsberechtigung im Unternehmen zu bewahren. Zu oft nämlich konnte er in der Vergangenheit das Delivery-Versprechen mangels verfügbarer Daten nicht einlösen und die damit verbundenen Erwartungshaltungen nicht erfüllen. An der Schnittstelle von Architektur und Datenmanagement wird gleichzeitig die Stellung des Data Engineers mit entsprechend großem Potenzial massiv nach oben gehen. Zu seiner strategischen Schlüsselposition als Garant für das zuverlässige Funktionieren der Analytics Infrastruktur gehört dabei auch das Thema Data Governance. Dieses ist 2020 ein absolutes Top-Thema und schließt nicht zuletzt wieder den Kreis zur Schaffung einer Data-Management-Organisation, Quelldokumentation und letztendlich damit der Grundlage zur Erzielung von Business Value.

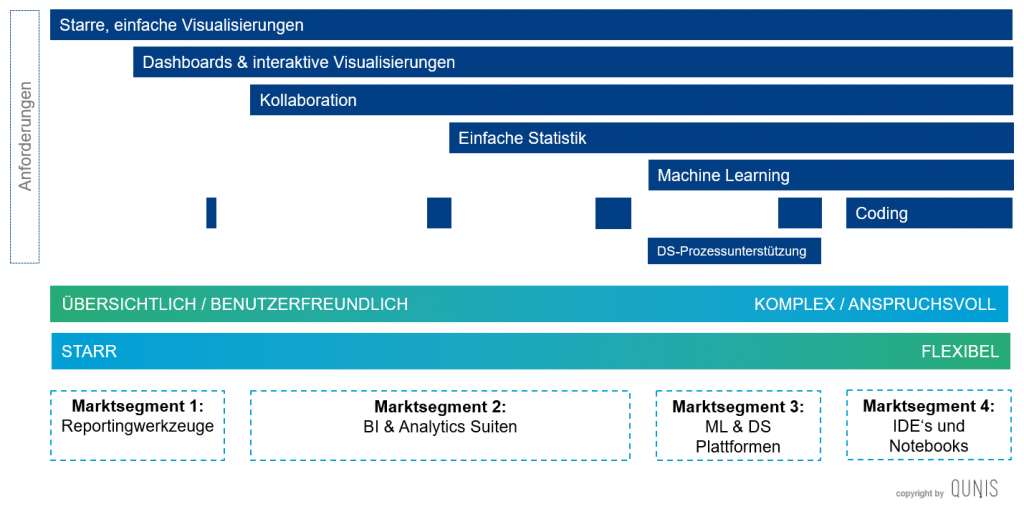

Mein Tipp: QUNIS hat ein Klassifizierungsschema entwickelt, das Ihnen hilft, Analytics-Use-Cases einzuordnen und zu identifizieren, an welcher Stelle Sie mit Ihrem B-I und Analytics-Projekt welchen Business-Value erzielen können und womit gegebenenfalls nicht. Mehr zum QUNIS BUSINESS CLASSIFICATION FRAMEWORK erfahren.