Das Thema Data & Analytics hat deutlich an Fahrt aufgenommen: Die Initiale für Projekte und Initiativen sind dabei so vielfältig wie nie zuvor. Die Herausforderungen und Antworten darauf ebenso.

Viele Organisationen stellen sich aktuell IT-seitig komplett neu auf

Aus selbst definierten strategischen Gründen oder auch weil technische Erweiterungen von Softwareherstellern eine komplett neue Ausrichtung erfordern. Dabei wird kaum noch monolithisch alles einer einzigen, zentralen Strategie untergeordnet. Stattdessen eröffnen sich heterogene Welten beispielsweise mit Cloud-Angeboten, Spezialapplikationen unter anderem für Product-Lifecycle-Management oder Firmendatenbanken wie etwa Produktinformationssysteme.

Diese Entwicklung erfordert angesichts der Vielfalt und Komplexität der Aufgaben im Kontext von Data & Analytics umso mehr feste Konzepte für das Stamm- und Metadaten-Management. Schließlich gilt es, jederzeit den Überblick zu bewahren und Transparenz zu gewährleisten.

Ebenso geht nicht erst seit, aber forciert durch Corona der Trend hin zum verteilten Arbeiten. Sogar Unternehmen, die sich vor nicht allzu langer Zeit noch dagegen gesperrt haben, stellen mittlerweile Digital Workplaces bereit. Auch hier spielt die Cloud eine zunehmend wichtige Rolle, um den mobilen Zugriff auf die Systeme etablieren und von der Infrastruktur her überhaupt ausrollen zu können. Über die Technologie hinaus erfordert dies vielfach neue Konzepte und Handlungsweisen.

Zudem betrifft die Digitalisierung die unterschiedlichsten Bereiche in einem Unternehmen – ob in der Kommunikation, im Vertrieb, dem Kundenservice oder der HR-Abteilung. Neben dem elementaren Organisationsmanagement, das die Struktur des „Gesamtkonstrukts Digitalisierung“ steuern und optimieren soll, benötigen diese Transformations- oder vielmehr Veränderungsprozesse immer auch ein gutes Change Management. Denn nicht nur die Prozesse müssen stimmen, sondern die Menschen dahinter müssen abgeholt und mitgenommen werden, um die veränderten Prozesse dauerhaft und erfolgreich im Unternehmen zu etablieren.

Damit einher geht auch der steigende Bedarf an Kompetenzen, dem sogenannten Upskilling. Die zunehmend digitalisierte Arbeitswelt erfordert abteilungsübergreifende Kompetenzerweiterungen; das gilt für den IT- und Technik-Bereich, aber auch in Marketing & Kommunikation und erstreckt sich ebenso über Anforderungen wie Mitarbeiterentwicklung, Problemlösungskompetenzen oder Konfliktmanagement bzw. Teamwork. Das alles muss bedacht und umgesetzt werden, da sonst Digitalisierungsinseln entstehen und ein Scheitern des ganzheitlichen Ansatzes vorprogrammiert ist.

Datenlandschaften gehören erweitert, sichere Zugänge gewährleistet

Immer bedeutender werden die sogenannten Digitalen Zwillinge oder auch Digital Twins. Dabei handelt es sich um digitale Nachbauten von physischen Objekten, Produkten und Services. Diese müssen in die Prozesslandschaften integriert werden, damit Simulationen und Forecasts rein digital stattfinden können – interessant ist dies beispielsweise für Produktentwicklung oder Qualitätsmanagement.

Die Daten als erfolgsentscheidendes Asset zu begreifen und entsprechend zu nutzen, bedeutet in der Konsequenz: Alle Mitarbeiter müssen im Sinne von Data Literacy (ein neu aufgekommenes Buzzword) möglichst einfachen Zugang zu den Daten haben – und dies umso mehr an den Stellen, an denen sie Potenzial zu einem echten Mehrwert mitbringen. Das zu ermöglichen, zeigt sich als weiterer Treiber für Data & Analytics-Projekte.

Durch all dies zieht sich der effiziente und nachhaltige Schutz der Daten wie ein roter Faden. Dabei geht es sowohl um alltägliche Dinge wie Zugriffsrechte als auch um heikle Themen, Stichwort Cyber-Kriminalität. Hier stellt der Gesetzgeber teils klare Forderungen. Vor diesem Hintergrund sind deutlich strukturiertere Vorgehensweisen erforderlich, als sie bislang vielerorts praktiziert wurden.

Das gilt ganz speziell für das Umfeld von Data & Analytics, wo aus bloßen Daten wahre Datenschätze entstehen und zu schützen sind. Gerade in Cloud-Umgebungen muss man genau hinsehen, wo genau und wie die Daten gespeichert werden und wer Zugriff darauf hat.

Datengetriebene Produkte und Services schüren Innovationskraft

Sah es noch vor einem Jahr n ganz anders aus, so werden heute bei uns viel mehr Add-Ons zu den Bestandsprodukten, Erweiterungen zu bestehenden Devices oder auch Zusatzservices und Dienstleistungen nachgefragt. Dieser Trend zur Anbindung von Geräten zeigt sich auch im privaten Umfeld, wo sich mittlerweile der Kühlschrank, die Heizung, das Auto und anderes mehr problemlos mit dem Internet verbinden lassen.

Viele Unternehmen wollen darüber ihr bisheriges Business-Modell von Verkaufen auf Vermieten umstellen, um so neuen Marktanforderungen gerecht zu werden. Auch hier entstehen große Mengen an hochwertigen Daten, die in der Analytics-Welt gewinnbringend genutzt werden können. Ein Beispiel von vielen: In unseren Kundenprojekten nehmen wir verstärkt einen Trend zur Produktindividualisierung wahr.

Hierfür stehen die Organisationen jedoch vor der Herausforderung, möglichst genau zu wissen, an welcher Stelle sie mit der Individualisierung ansetzen können und inwieweit dies überhaupt lohnenswert ist. Die notwendigen Daten dafür liefern Data & Analytics.

Technologie wird zum Service

Es zeichnet sich ganz allgemein eine Entwicklung dahingehend ab, dass die technologischen Konzepte, die in den vergangenen zehn bis fünfzehn Jahren gut funktioniert haben, in unseren zunehmend dynamischen Zeiten an ihr Limit stoßen: Aktuelle Herausforderungen erfordern moderne und innovative Methoden und Werkzeuge. Unternehmen müssen daher konkrete Überlegungen über ihre künftige Ausrichtung anstellen.

In diesem Kontext wird Technologie zum Service. So gehen derzeit zwischen 70 und 80 Prozent aller neu begonnenen Projekte von QUNIS in Richtung Cloud-orientierter Nutzung von Services. Die Organisationen bauen nicht mehr inhouse Technologien auf, sondern verwenden teils komplette Softwarelösungen verschiedener Cloud-Anbieter als Managed Services. Dabei wird je nach Anwendungsfall sehr häufig auch auf hybride Architekturen gesetzt, bestehend aus der Kombination von Cloud- und On-Premise-Systemen.

Generell jedoch ist festzustellen, dass Cloud-Architekturen nicht mehr nur auf dem Vormarsch sind, sondern speziell in der Data & Analytics-Welt sogar überwiegen.

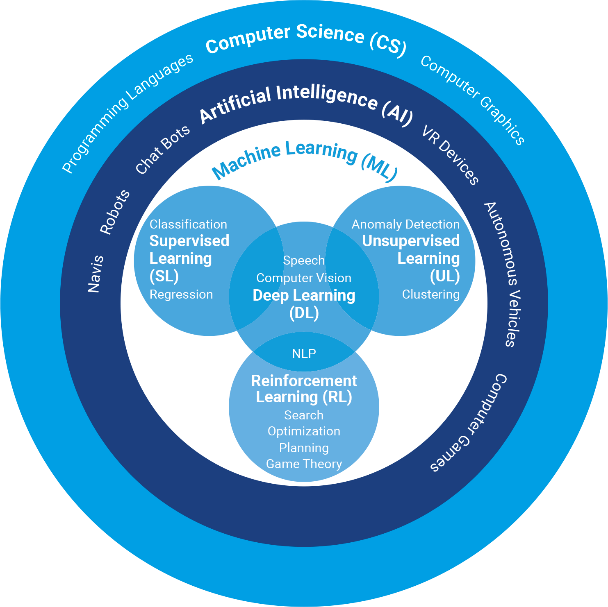

Oft nämlich könnten die Unternehmen die angebotenen Services gar nicht eigenständig betreiben, weil ihnen die erforderlichen Ressourcen und das entsprechende Know-how für die teils sehr komplexen Technologien fehlen. War es beispielsweise in früheren Zeiten noch mit dem Aufbau eines kleinen Data Warehouses getan, sind heute deutlich mehr Spezialtechnologien notwendig wie etwa Machine-Learning-Algorithmen.

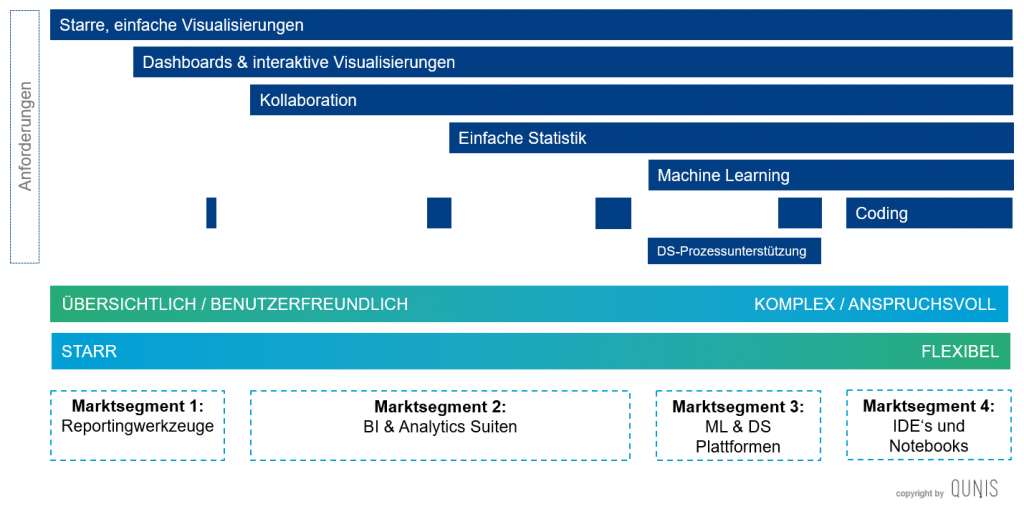

Immer mehr Daten werden in zunehmend mehr Anwendungsfällen verarbeitet. Aufgrund dessen wird eine nochmals verbessere Usability für die Nutzer mit möglichst niedrigen Eintrittshürden schlichtweg erfolgsentscheidend bei der Anwendung der unterschiedlichen Technologieprodukte.

Hier bewähren sich Business-Glossars und Data Catalogs, mit denen sich die zunehmenden Datenvolumina automatisiert ordnen und vereinheitlichen lassen. Metadaten-Management-Lösungen können dabei helfen, mit den Daten und modellierten Inhalten besser und unkomplizierter zu arbeiten.

Data & Analytics wächst und weitet sich aus

Branchenübergreifend zeigt sich, dass Organisationen fachlich gesehen mit immer heterogeneren Datenformaten umzugehen haben, um daraus ihre Erkenntnisse zu gewinnen. Dazu zählen im Kontext von Data & Analytics beispielsweise Sensordaten und Texte, aber auch Bild- und Audio-Material.

Gleichzeitig werden die Anwendungsfälle tendenziell businesskritischer. Bislang beispielsweise war ein kurzfristiger Ausfall des BI-Systems nicht sonderlich problematisch, weil es nicht direkt relevant für die operative Ebene war, sondern lediglich steuernd und informativ. Heute hingegen greifen wir hierüber in Echtzeit tief in die Prozesse hinein und generieren Erkenntnisgewinne für die operative Steuerung etwa von Produktions- oder Logistikprozessen oder hinsichtlich der Up- und Cross-Selling-Potenziale von Webshops.

Zudem verzeichnen wir stetig komplexere Self-Service-Anforderungen. Die Nutzer möchten etwa nicht mehr nur schnell ein einfaches Dashboard selbst bauen. Sie fordern vielmehr technologische Strukturen, um über den Self-Service-Ansatz beispielsweise Massendaten selbstständig auswerten zu können. Da es ihnen hierbei jedoch an der jahrelangen Erfahrung echter Experten mangelt, entsteht entsprechender Anleitungsbedarf – dabei müssen Standardisierung und Harmonisierung natürlich jederzeit gewährleistet bleiben.

Wahl der Plattform wird zweitrangig

Bei der Wahl der Infrastruktur gibt es für Unternehmen verschiedene Optionen: On-Premise, Public Cloud in Form von PaaS und SaaS oder Container-Strategien. Häufig nutzen Unternehmen auch eine Multi-Cloud-Strategie mit mehr als nur einem Hyperscaler. Eine wichtige Rolle spielt hier die Portierbarkeit, damit zu jeder Zeit die Flexibilität erhalten bleibt, den Cloud-Anbieter gegebenenfalls problemlos wechseln zu können. Alternativ entscheiden Organisationen sich von vornherein für eine hybride Lösung aus Cloud und On-Premise.

Nicht zuletzt wird die Rolle von Open-Source-Technologie zunehmend bedeutender. In der klassischen BI-Welt weniger eingesetzt, kommt sie im Umfeld von Streaming, Big Data, Machine Learning sowie bei Prozessen auf Basis von Massendaten jetzt verstärkter zum Einsatz – mit dem Potenzial, den Markt nahezu zu dominieren.

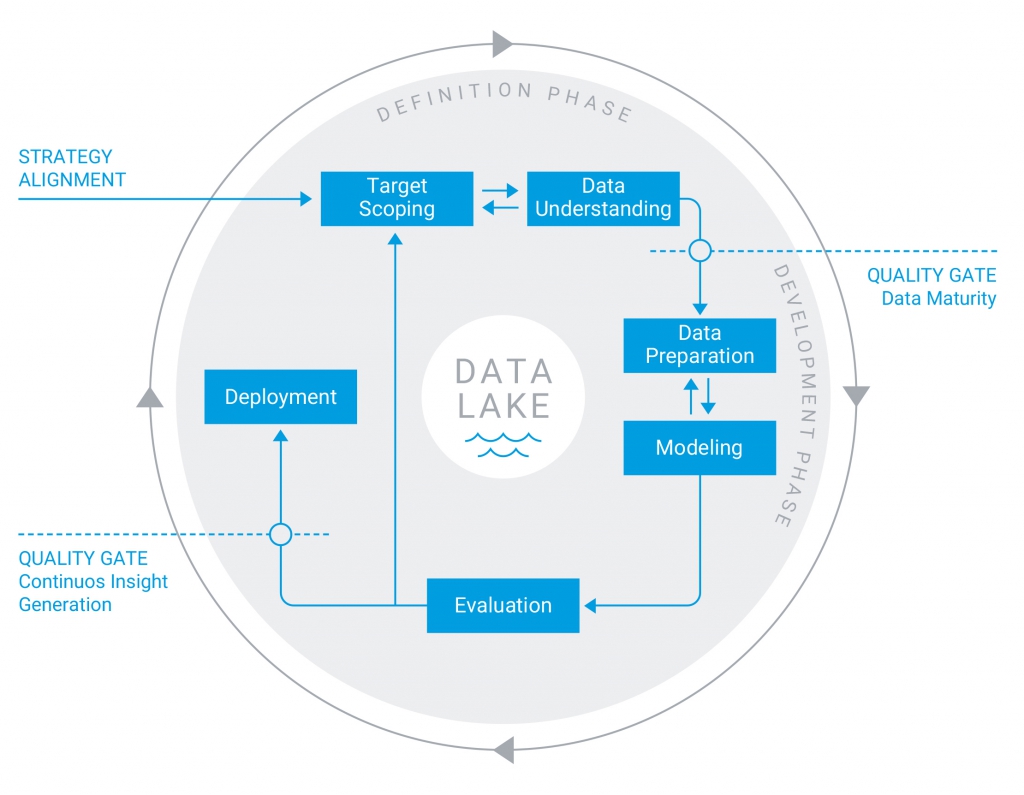

Data Management Units zur Umsetzung Ihrer Datenarchitektur

Das Thema Architektur und wie sich Architekturen verändern kann man derzeit als klaren Trend am Markt erkennen. In diesem Zusammenhang bieten wir bei QUNIS je nach der Zielsetzung, die Unternehmen mit ihrer jeweiligen Data & Analytics-Strategie verfolgen, sogenannte Data Management Units (DM Units) an. Diese bilden das Herzstück der Datenverarbeitung und -speicherung bei Data & Analytics-Initiativen.

Mit Self-Service-BI, Data Warehouse, Data Warehouse & Data Lake, Lakehouse und Streaming stehen insgesamt fünf DM Units mit einem jeweils unterschiedlichen Leistungsspektrum zur Verfügung.

Welche DM Unit für ein Unternehmen infrage kommt, hängt dabei immer von der Ausrichtung der künftigen Architektur ab. Die Entscheidung darüber sollte stets vorab getroffen werden, weil sich etwa die eher pragmatische Variante Self-Service-BI im Nachhinein nicht so schnell in ein komplexeres Lakehouse umwandeln lässt. Mit verschiedenen Add-Ons lassen sich die zentrale Datenspeicherung und -verarbeitung der DM Units modular um zusätzliche Funktionen erweitern. In jedem Fall notwendig sind Visualization & Reporting, Monitoring und Process Control, hinzu kommen optionale, teils kombinierbare Add-Ons wie beispielsweise für API, Virtualisierung oder Metadaten-Management wählbar.

Ihr Thema ist mit dabei? Sie haben sich und Ihre aktuellen Herausforderungen widererkannt und wünschen sich dafür Beratung und Begleitung von QUNIS und unseren Experten?

Sprechen Sie einfach Ihren QUNIS-Berater*in an oder schreiben Sie direkt eine E-Mail an team@qunis.de und verraten Sie uns ein wenig mehr zu Ihrer Motivation, Ihren Zielen und Vorhaben. Wir freuen uns auf den Austausch und die Diskussion mit Ihnen.