Die Schreiner Group ist ein international tätiges Familienunternehmen, das innovative Hightech-Labels und Funktionsteile vor allem für die Pharma- und Automobilindustrie entwickelt und produziert. Mit zukunftsweisenden Produkten wie smarten RFID-Lösungen, Druckausgleichselementen für Elektronik-Gehäuse oder Schutzfolien erzielt die Schreiner Group einen Jahresumsatz von über 200 Millionen Euro. Die Controlling-Abteilung hat zusammen mit QUNIS ein Cloud-basiertes Data Warehouse implementiert. Die BI-Lösung bildet den Kern einer zentralen Datenplattform, die schrittweise im gesamten Unternehmen ausgerollt wird.

Unser Data Warehouse ist hoch professionell, standardisiert, nachvollziehbar und skalierbar. Die moderne Data & Analytics-Architektur erschließt SAP-Daten für unsere Fachbereiche.

Matthias Lindemann,

BI Solution Architect, Schreiner Group GmbH

Data & Analytics-Implementierung parallel zur SAP-Einführung

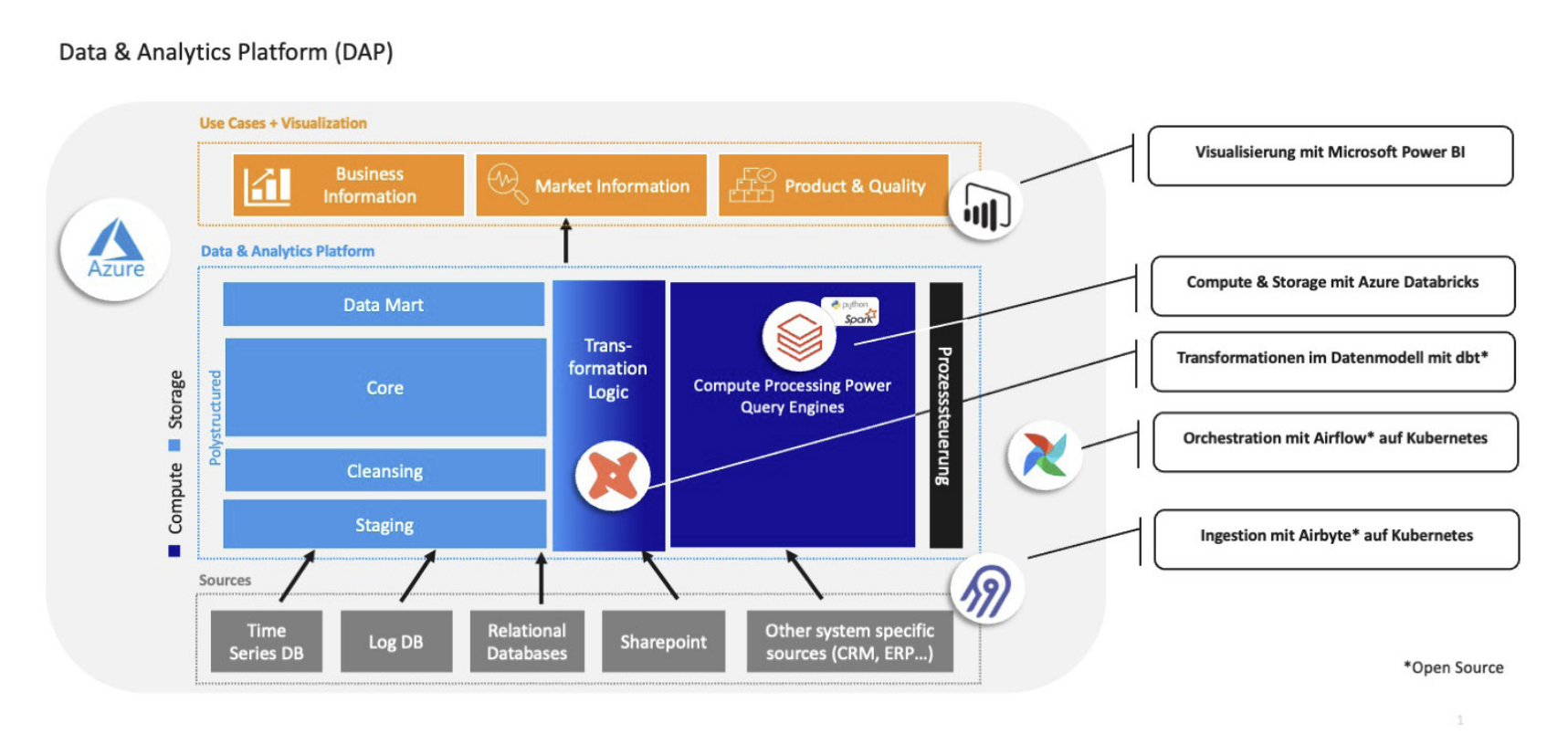

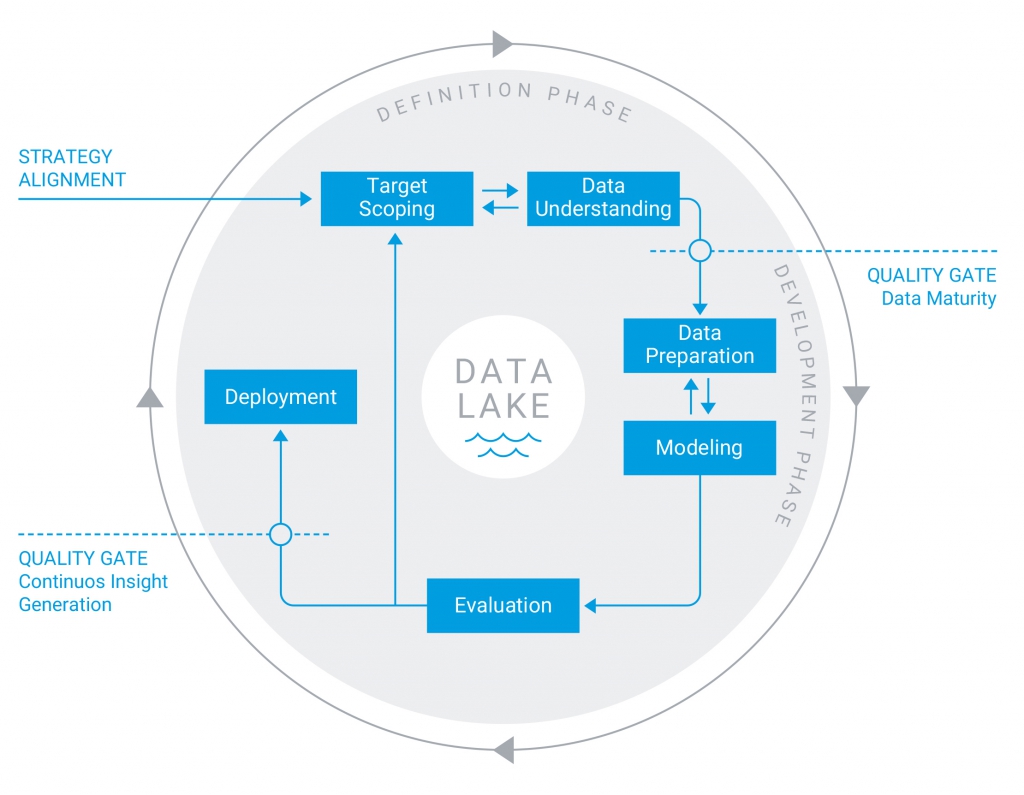

Im ersten Schritt sollte ein modernes Data Warehouse (DWH) implementiert werden, das eine einheitliche Datenbasis für Reporting und Analyse schafft. Die Systemarchitektur sollte dabei als ausbaufähige Datenplattform angelegt werden, die in späteren Projektphasen beispielsweise durch einen Data Lake ergänzt werden kann.

Der projektverantwortliche BI Solution Architect Matthias Lindemann hebt die hochprofessionelle und fokussierte Beratung durch QUNIS hervor: „Die Strategie-Workshops waren sehr effektiv. QUNIS hat uns gezielt zur passenden Data & Analytics-Lösung geführt.“

Nach der erfolgreichen Zusammenarbeit bei der Strategieentwicklung hat sich die Schreiner Group bei der Realisierung des Data Warehouse ebenfalls für QUNIS als Implementierungspartner entschieden. Das DHW-Projekt fand dabei unter besonderen Rahmenbedingungen statt: Die Schreiner Group löst ihr bestehendes ERP-System auf Basis einer AS/400-Datenbank schrittweise durch SAP ab. Dadurch ergibt sich derzeit ein Parallelbetrieb zweier ERP-Systeme mit ganz unterschiedlichen Datenstrukturen.

Ein wesentliches Ziel des neuen Data Warehouse ist, den Controllern und Fachanwendern einen einfachen Zugriff auf konsolidierte Daten aus beiden ERP-Systemen zu ermöglichen. Gerade im SAP-Umfeld werden sämtliche Ladestrecken neu konzipiert und schrittweise realisiert.

Pilotprojekt in der Cloud

Die Einführung von Azure war für die Schreiner Group aufgrund der speziellen Herausforderungen einer Cloud-Umgebung Neuland und erwies sich als aufwändiger als zunächst angenommen. QUNIS und die auf Cloud-Projekte spezialisierte Schwesterfirma TEQWERK, die zeitweise ebenfalls involviert war, waren hier insbesondere hinsichtlich der internen Positionierung des Projekts sehr hilfreich.

Matthias Lindemann erklärt, dass die professionelle Implementierung und Moderation u. a. die interne IT überzeugt, Vertrauen geschaffen und damit die Umsetzung der vom BI Board favorisierten Cloud-Lösung ermöglicht haben. Die Azure-Umgebung wird derzeit von der IT-Abteilung der Schreiner Group betreut. Eine Auslagerung an TEQWERK steht als mögliche Alternative im Raum.

Flexible Auswertung von SAP-Daten

Zum Aufbau des Data Warehouse kam das QUNIS Data Warehouse Framework (QDF) zum Einsatz. Das Vorgehensmodell mit Best Practices, Templates und vordefinierten Prozessen sorgt für eine schnelle und sichere Implementierung und Bewirtschaftung des Data Warehouse.

- Der Schwerpunkt im Projekt lag auf der Erschließung der SAP-Daten für den Fachbereich. Auf Empfehlung von QUNIS wurden die SAP-internen Business Logiken nicht übernommen, sondern eigene Ladestrecken mit Direktzugriff auf die einzelnen SAP-Tabellen definiert. Damit erhält der Fachbereich höchste Flexibilität beim Aufbau und der Auswertung seiner Datenmodelle.

- Bei der Integration der ersten Use Cases arbeitete das interdisziplinäre Projektteam bereits mit den neu geschaffenen Rollen aus Fachbereichen, Prozessexperten, IT und Führungskräften eng zusammen. Inzwischen sind die Power User aus den Fachbereichen mit den SAP-Strukturen so vertraut, dass sie eigenständig die benötigten SAP-Tabellen ermitteln und hinsichtlich ihrer Reporting- und Analyse-Relevanz beurteilen.

- Die effiziente Zusammenarbeit zwischen Power Usern und den Data Managern aus der IT wird zudem durch das Data Dictionary unterstützt, das QUNIS in seinem QDF-Modell als Template bereitstellt. Die Power User nutzen das Tool als Drehbuch für die IT, um ihre Anforderungen professionell zu spezifizieren.

Auftragseingang als erster Use Case

Als erster Use Case wurde das Auftragseingangsreporting im Data Warehouse abgebildet. Im Prototyping-Verfahren wurden die ETL-Strecken und Datenmodelle definiert, der Auftragseingangsreport in Power BI abgebildet und die Lösung schrittweise weiter ausgefeilt.

Die Beteiligten der Schreiner Group haben sich im Projekt das entsprechende Know-how angeeignet und können nun das Umsatzreporting als zweiten Use Case komplett selbstständig aufsetzen. Matthias Lindemann benennt den Coaching-Ansatz von QUNIS als wesentlichen Vorteil: „Die Fachabteilung hat das Datenmodell verstanden und kann alle benötigten Auswertungen selbst zusammenstellen.“

Das neue Umsatz- und Auftragseingangsreporting vereint Informationen aus beiden ERP-Welten und wird das bestehende Sales Reporting aus dem bisherigen Reportingtool und Excel ablösen. Bisher arbeiten lediglich ausgewählte Power User und Controller mit Power BI. Ein Rollout von Power BI auf die End User und weitere Power User ist schrittweise je nach Umsetzung der nächsten Use Cases geplant.

Interne Weiterentwicklung

Mit dem Data Warehouse hat das Controlling schon während der SAP-Implementierung eine integrierte Berichtsplattform bereitgestellt. Ein wesentlicher Gewinn ist die im Lauf der Implementierung etablierte effektive Zusammenarbeit der Power User mit den Data Managern aus der IT auf Basis professioneller Requirements.

Die Power User haben die Datenbewirtschaftung und -bereitstellung heute selbst in der Hand und können die SAP-Daten flexibel auswerten. Auch die IT-Abteilung lobt das hoch automatisierte Data Warehouse, das einen sicheren Betrieb mit einfacher Wartung, strukturierter Weiterentwicklung und gleichbleibend hoher Performance gewährleistet: „Das Data Warehouse ist hoch professionell, standardisiert, nachvollziehbar und skalierbar.“

Die Data & Analytics-Plattform wird zunehmend verschiedene BI-Produkte und Insellösungen der Fachbereiche ersetzen, was die IT-Administration vereinfacht und Kosten für Software-Updates und diverse Lizenzen spart.

Organisatorisch hat das neu geschaffene BI Competence Team (BICT) unter der Leitung des Controllings hierfür bereits alle BI- und Analytics-Initiativen der Schreiner Group zusammengefasst. Darüber hinaus gestaltet das BICT die Weiterentwicklung der unternehmensweiten Data Governance und ist in Architekturfragen hinsichtlich der Analytics und des Reportings wichtiger Ansprechpartner.

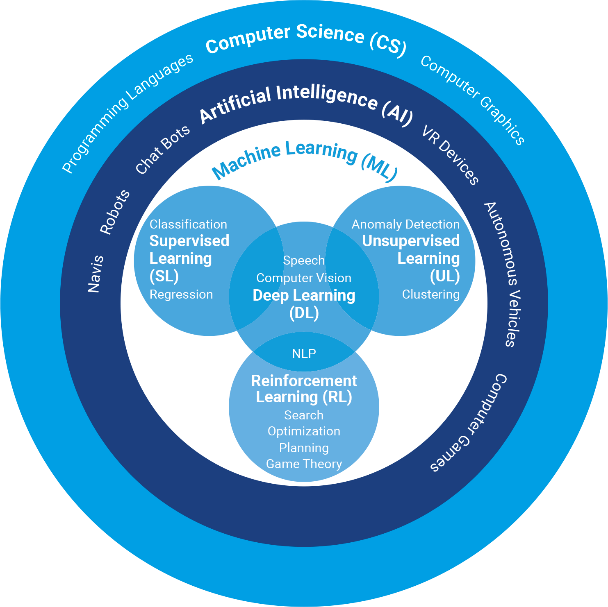

Das Controlling treibt derzeit die Umsetzung und den Rollout von Reporting und Analyse in Power BI weiter voran. QUNIS wird für diese Ausbaustufen lediglich punktuell benötigt und steht für Fragen bereit. Desweiteren stehen die Themen Aufbau und Integration einer neuen Planungslösung, Big Data, Integration von KI-Anwendungen und die damit verbundene Weiterentwicklung der Azure-Architektur auf der Roadmap.

Mehr zur Schreiner Group: Die Schreiner Group GmbH & Co. KG ist ein international tätiges deutsches Familienunternehmen und gilt als bevorzugter Partner in den Märkten Healthcare und Mobility. Der „Hidden Champion“ aus Oberschleißheim im Landkreis München hat weltweit vier Standorte (u.a. in Shanghai und New York) und liefert in rund 60 Länder. Das Kerngeschäft sind Funktionslabels in Top-Qualität, die um ergänzende Systemlösungen und Dienstleistungen angereichert werden. Die innovativen Hightech-Labels und Funktionsteile der Schreiner Group erschließen smarte Lösungsdimensionen und helfen, das Leben ein Stück gesünder, mobiler und sicherer zu machen. www.schreiner-group.com

Mehr zu QUNIS Implementierung: QUNIS Implementierung