Danone gehört zu den führenden Lebensmittelherstellern weltweit. Eine globale Plattform für Data & Analytics hilft bei der operativen und strategischen Steuerung des Konzerns. Für den Bereich Danone D-A-CH hat QUNIS eine Sell-Out-Applikation realisiert, die sich nahtlos in die zentrale Datenplattform einfügt.

Wir waren uns sicher, dass QUNIS den Use Case in selbstständiger Arbeit erfolgreich abliefert.

Tobias Riedner,

Head of IT Data & Analytics, Danone Deutschland GmbH

Data Journey bis 2025

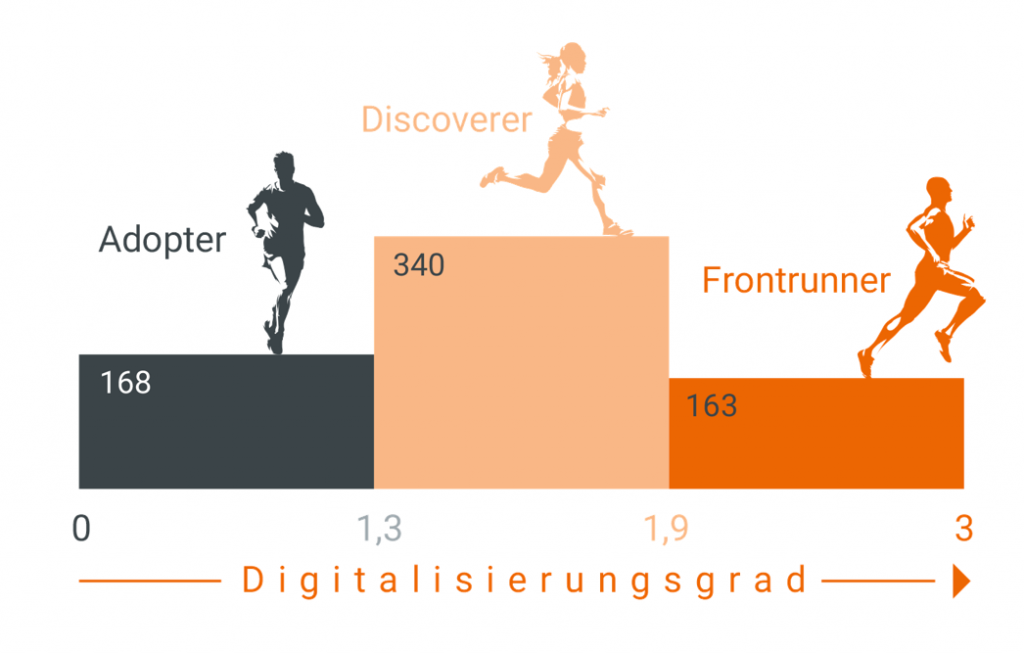

Danone verfolgt eine konsequente Digitalisierungsstrategie. Im Jahr 2020 hat das Unternehmen eine auf fünf Jahre angelegte Initiative zu den Themen Cloud, Data Products und Data Driven Decisions gestartet und in diesem Rahmen eine zentrale Datenplattform für Data Sourcing und Provisioning aufgebaut. Seit dem Rolling Out der „One Source“-Plattform im Jahr 2022 werden kontinuierlich neue Use Cases aufgesetzt.

Die benötigten Datenprodukte für die Anwendungen werden vom Bereich IT Data & Analytics zur Verfügung gestellt und gewartet. Für die Umsetzung einer Sell-Out-Applikation hat das IT-Team QUNIS als Implementierungspartner hinzugezogen. Die internen Core DevOp Teams, die unternehmensweit Datenprodukte bereitstellen, hatten zu diesem Zeitpunkt nicht die nötigen Kapazitäten für diesen strategisch wichtigen Use Case. Als zentrales Steuerungsinstrument für den Bereich Danone D-A-CH wurde der Sell Out Use Case jedoch dringend benötigt.

Use Case an QUNIS delegiert

QUNIS war bei Danone bereits seit Jahren als projekterfahrener Experte für Data & Analytics bekannt. Für Tobias Riedner, Head of IT Data & Analytics der Danone Deutschland GmbH, war daher klar, dass er sich auf QUNIS als kompetenten Implementierungspartner verlassen kann: „Wir waren uns sicher, dass QUNIS den Use Case in selbstständiger Arbeit erfolgreich abliefert.“

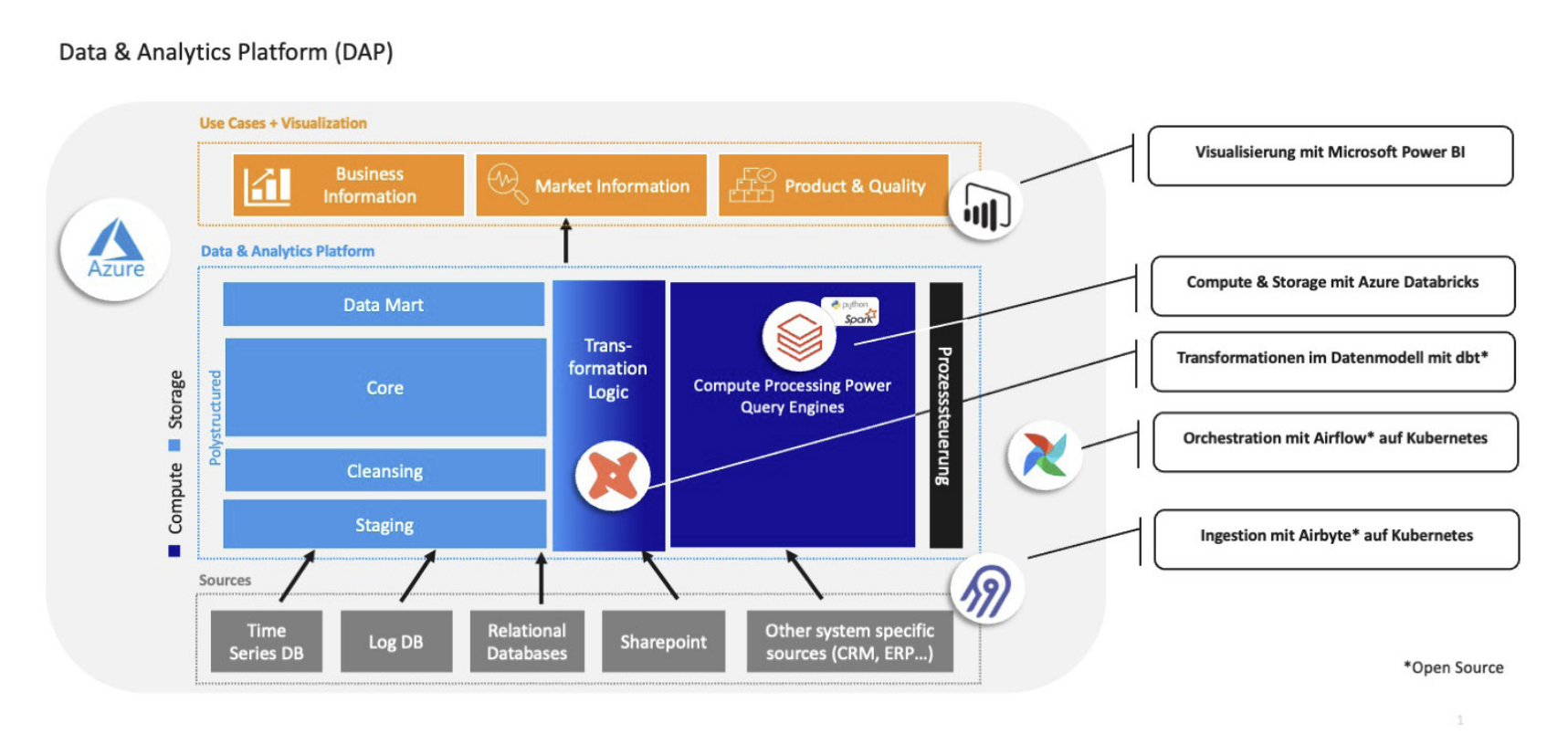

Im Projekt galt es, den spezifischen Use Case im Rahmen der vorgegebenen globalen Referenzarchitektur umzusetzen. Die One-Source-Datenplattform von Danone ist ein Data Lakehouse auf der Basis von Microsoft Azure, mit vielfältigen Vorsystemen, mit Databricks und Snowflake Datenspeichern und Power BI als Frontend für die Berichtsempfänger.

Für Tobias Riedner war wichtig, dass QUNIS in dieser Technologieumgebung eine große Expertise und umfangreiche Projekterfahrung mitbringt. Aber auch die Tatsache, dass QUNIS zuvor bereits eine ähnliche Anwendung mit anderer Technologie umgesetzt hatte, sprach für eine schnelle und sichere Implementierung.

Wichtige Steuerungskennzahlen

Der Sell Out Use Case ist eine klassische BI-Anwendung, allerdings fachlich und hinsichtlich des Datenmanagements sehr komplex. Danone vertreibt seine Produkte fast ausschließlich als B2B-Händler an den Einzelhandel. Der Verkaufspreis an Händler wie Aldi oder ReWe wird als „Sell In“ geführt. Zu welchem „Sell-Out“-Preis der jeweilige Einzelhändler die Produkte an die Konsumenten abgibt, ist für Danone eine wesentliche Information für die Preissteuerung. Aus der Marge zwischen Sell In und Sell Out, oder der Sell-Out-Nachfrage für das Produkt, ergeben sich Hinweise zur Preissensitivität der Endkunden, die wiederum Auswirkungen auf die eigene Preisgestaltung und darüber hinaus auch auf die Produktions- und Lagersteuerung oder auf Marketingaktionen haben.

Datenmanagement automatisiert

Danone erhält für diese Analyse Flat-Files von den Einzelhändlern, die vor der Neuimplementierung manuell gesammelt und aufbereitet wurden. Die Prüfung und Zusammenführung der Daten war zuvor entsprechend aufwändig und fehleranfällig. Wegen des hohen Aufwands war zudem nur eine monatliche Aktualisierung möglich.

Die Data Engineers von QUNIS haben das Datenmanagement neu aufgesetzt. Die teilautomatisiert gesammelten Dateien der Händler werden nun intern vollautomatisch verarbeitet, in das Data Lakehouse integriert und zur Auswertung bereitgestellt. Eine wesentliche Herausforderung im Projekt war dabei die Harmonisierung von Hunderten angelieferter Excel- und Textfiles, u. a. auch mit unterschiedlichen Berichtszeiträumen der Händler.

© Burda Food Agency / Katrin Winner

Leistungsstarke Datenmodelle

Bei der Datenmodellierung war die fachliche Expertise von QUNIS gefragt. Die performanten Datenmodelle ermöglichen schnelle und flexible Auswertungen für unterschiedliche Fachbereiche. Das Datenprodukt wird für die Abteilung Price Revenue Growth Management (PRCM) bereitgestellt, die diese wiederum für Reporting und Analyse in verschiedenen Fachbereichen aufbereitet. Im Rahmen des PRCM-Prozesses können nun Bereiche wie Sales, Key Account Management oder Produktion ihre Fragen zur Preissensibilität der Endkunden mit flexibler Sicht auf die Verkäufe, Preise, Händler oder Regionen beantworten, Produktionsmengen steuern oder Lieferungen zu Händlern oder in bestimmte Regionen präzise terminieren. Tobias Riedner fasst zusammen:

Die Sell-Out-Applikation ist für unsere Unternehmenssteuerung unverzichtbar. Dank QUNIS sind die aktuellen Kennzahlen heute auf Knopfdruck verfügbar.

Kompetenter Implementierungspartner

QUNIS wurde bei Danone vor allem als Experte für Data Engineering eingesetzt. Wichtig ist dabei jedoch auch der Blick für das Big Picture der globalen Datenplattform. Die Architektur der Sell-Out-Lösung fügt sich nahtlos in die Gesamtarchitektur ein, kann im Rahmen der standardisierten Technologieumgebung beliebig ausgebaut werden und lässt sich zugleich an die ständig weiterentwickelte Datenplattform anpassen.

Die Zusammenarbeit mit QUNIS war großartig. Bei Bedarf werde ich jederzeit wieder darauf zurückgreifen.

Mehr zu Danone: Danone ist einer der führenden Hersteller von Lebensmitteln und medizinischer Ernährung in der D-A-CH-Region, der in vier Geschäftsbereichen tätig ist: Milchfrische, pflanzenbasierte Produkte, natürliches Mineralwasser und Erfrischungsgetränke sowie frühkindliche und medizinische Nahrung. Mit rund 2.300 Mitarbeitern an sieben Standorten sowie zwei international relevanten Werken produziert Danone D-A-CH über 1.000 unterschiedliche Produkte. Das Portfolio umfasst führende internationale und lokale Marken wie Actimel, Activia, Alpro, Aptamil, Volvic, evian, Fruchtzwerge, Nutrini, Fortimel und Neocate. Weltweit ist Danone mit mehr als 96.000 Mitarbeitenden in über 55 Ländern Marktführer in den Bereichen Dairy & Plant Based Products, Spezialized Nutrition und Waters. Die Danone Produkte sind in mehr als 120 Ländern erhältlich. Weitere Informationen: www.danone.de

Kostenfreies Whitepaper QUNIS Quick Guide to Open Lakehouse

Mehr zur QUNIS Implementierung