An die Datenauswertung im Unternehmen werden heute immer größere Anforderungen gestellt. Das zentral angesiedelte BI Competence Center, das bislang die Entwicklung und das Datenmanagement rund um ein Data Warehouse erledigt hat, kommt damit aber immer mehr an seine Grenzen. Das Prinzip des Data Mesh bietet hier einen passenden Lösungsansatz.

Data Mesh macht Analytics agiler

Data Mesh stellt die Daten als Wertschöpfungsfaktor in den Mittelpunkt der Architekturkonzeption. Daten sollen als „Datenprodukte“ prozess- und systemübergreifend im Unternehmen zur Verfügung gestellt werden.

Die Grundidee besteht darin, Daten als Asset für die Organisation zu begreifen und Business Usern hochwertige Datenprodukte für ihre Zwecke zugänglich zu machen, damit sie diese optimal nutzen können. Diesen Ansatz verfolgt auch die Self-Service BI bereits seit Jahren.

Neu ist bei Data Mesh allerdings die konsequente Delegation der Verantwortung und Kompetenzen in die dezentrale Organisation:

- Entwicklungsteams erhalten die Verantwortung für die Entwicklung und den Betrieb von Datenprodukten ihrer fachlichen Domäne.

- Die Verlagerung in fachlich geschnittenen Domänenteams löst das Engpass-Problem eines einzelnen zentralen Analytic-Teams.

- Zugleich vervielfacht sie die Entwicklungsressourcen, erhöht damit das mögliche Umsetzungstempo neuer Use Cases und gewährleistet darüber hinaus die geforderte fachliche Expertise in der jeweiligen Domäne.

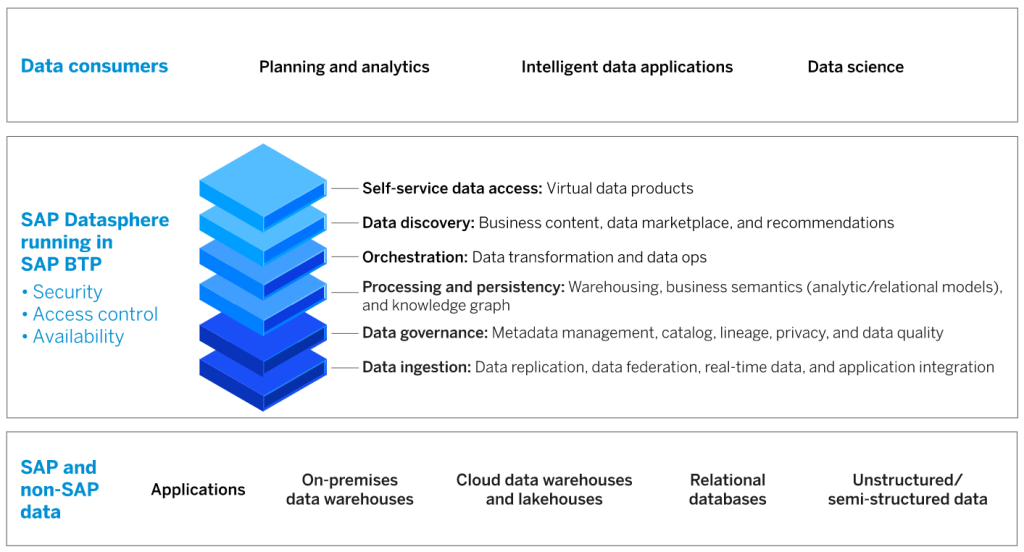

Die Dateninfrastruktur für die Domänenteams wird in Form einer Datenplattform nach dem Self-Service-Gedanken bereitgestellt. Im Gegensatz zur klassischen Data-Warehouse-Architektur mit zentralisierten Datenströmen handelt es sich hier um eine domänenorientierte dezentrale Architektur für analytische Daten.

Die Definition von Data Mesh zielt eher auf die Governance und Organisation des datengetriebenen Unternehmens ab als auf technologische Aspekte. Es gibt aber eine Kernarchitektur, die sich zur Umsetzung von Data Mesh besonders eignet, das Data Lakehouse.

Data Lakehouse unterstützt Data Mesh

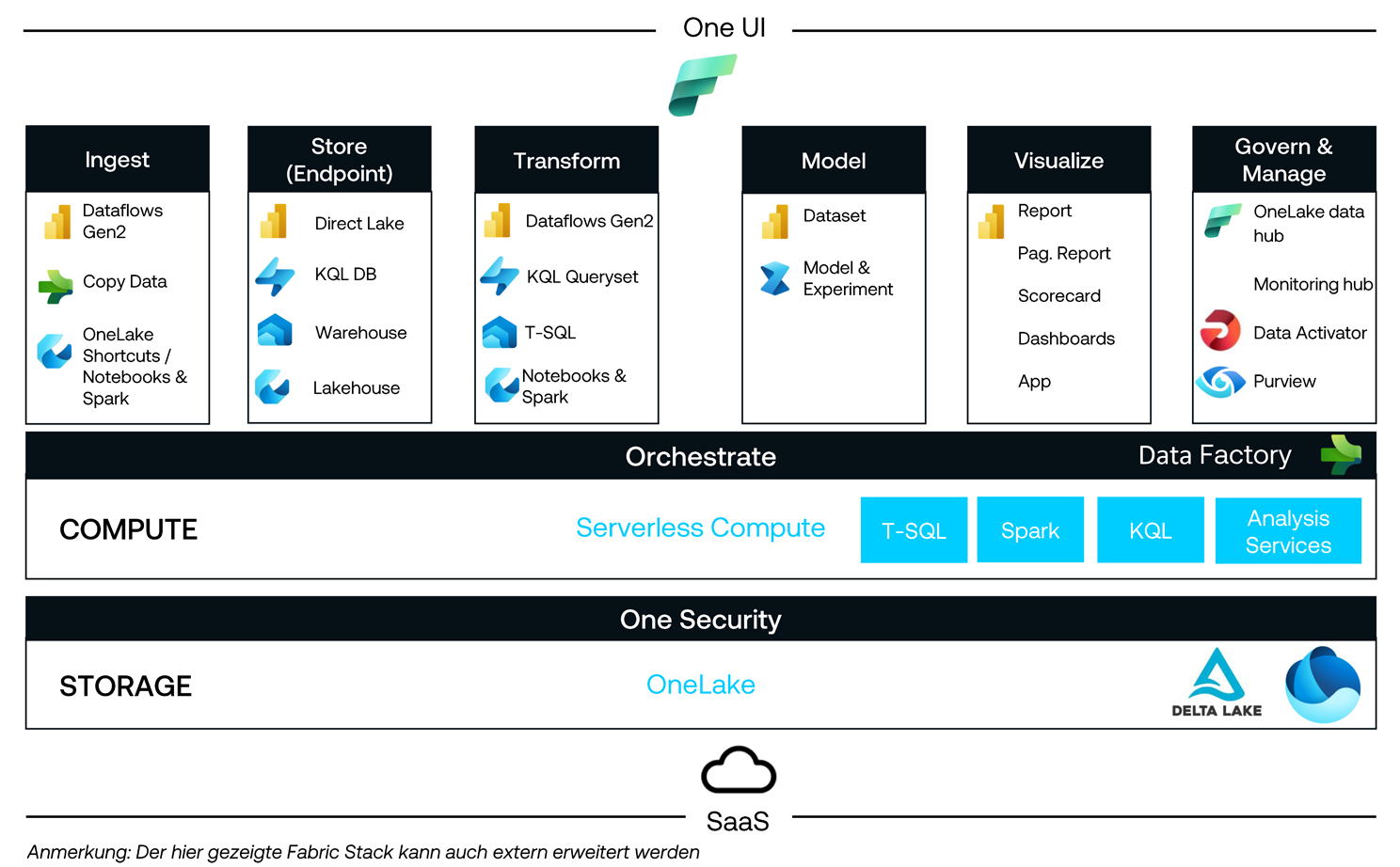

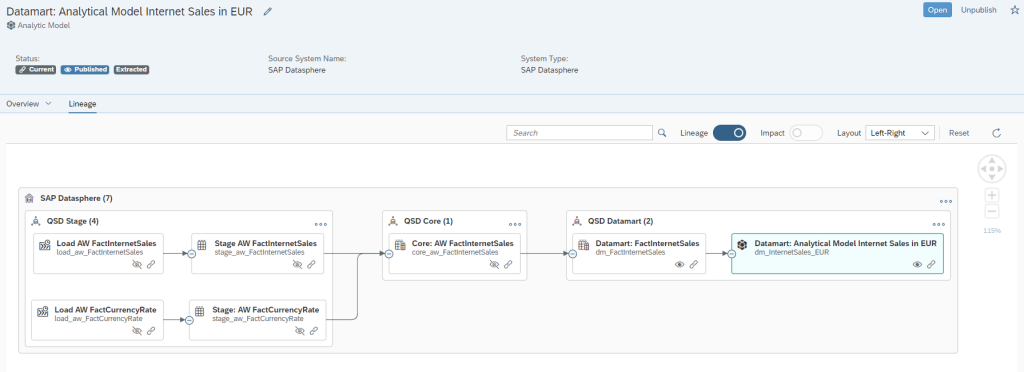

Das Data Lakehouse unterstützt die dezentrale Arbeit mit Datenprodukten. Durch die Trennung von Storage und Computing bietet es eine hohe Flexibilität zur Einrichtung verschiedener Domänen mit jeweils eigenen Datenprodukten auf einem gemeinsamen Datenlayer. Ein heterogener Technologie-Stack greift dabei über Open Table Format auf Daten aus verschiedenen Quellen zu und bereitet sie für Use Cases wie BI, ML, Data Science oder Data Engineering in diversen Domänen auf.

Unter Berücksichtigung einer stringenten Access Control lassen sich die Datenquellen auf diese Weise verschiedenen Teams für ihre Auswertungen zugänglich machen. Datensilos werden vermieden und domänenübergreifende Datenabfragen unterstützt. Das verteilte Computing ermöglicht es zudem, unvorhergesehene Lastspitzen aus anderen Domänen abzufangen.

Reifegrad der dezentralen Governance als Erfolgsfaktor

Gemäß Definition basiert Data Mesh auf den vier Grundprinzipien Domain Ownership, Data Products, Self-Service und Federated Governance. Die verteilte Governance ist dabei der wesentliche Erfolgsfaktor für die Etablierung von Data Mesh. Im Rahmen der Governance legen die beteiligten Teams gemeinsame Standards und Regeln fest, um ihre Zusammenarbeit, die Harmonisierung der Daten und Sicherheitsanforderungen zu gewährleisten.

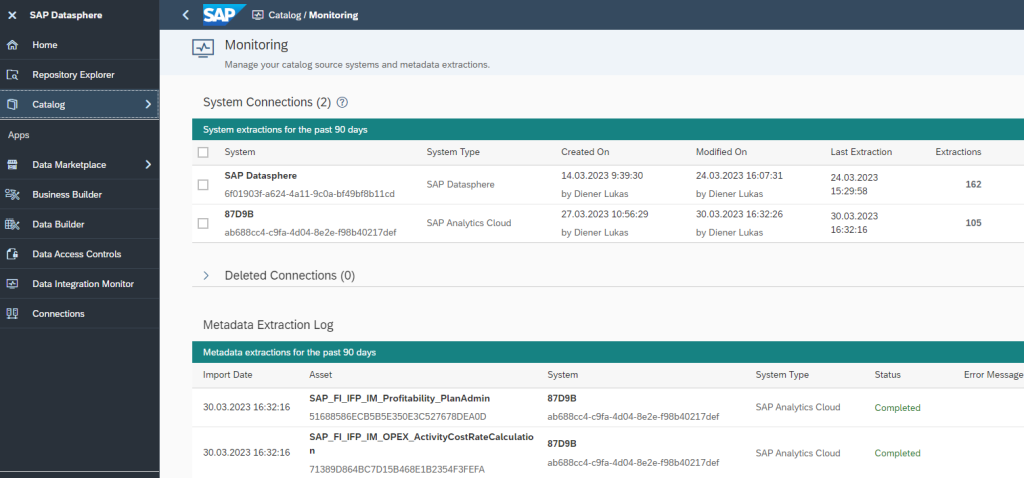

Aufgaben wie das Qualitätsmanagement und die Klassifikation von Daten, Security, Schnittstellen-Verwaltung oder die Definition und Verwaltung von Datenprodukten sind über die gesamte Organisation verteilt. Die Verantwortlichkeiten müssen hier klar geregelt sein.

QUNIS hat dafür ein dezidiertes Rollenmodell entwickelt, das sich seit Jahren in Data & Analytics-Projekten bewährt.

- Das Rollenmodell legt unter anderem das Ownership für Domänen, Datenprodukte oder Datenobjekte wie „Kunden“, „Artikel“ oder „Partner“ fest.

- Datenexperten wie Data Owner, Data Steward und das Data Governance Board arbeiten dabei mit Funktionen eines BI- oder erweiterten Analytics-Rollenmodells zusammen.

- Dazu gehören zum Beispiel die Rollen End User, Power User, Solution Architect, Data Engineer mit DataOps, Data Architect sowie Data Scientist mit MLOps.

Über das Rollenmodell kann der Data-Mesh-Gedanke bis hin zu den DevOps etabliert werden. Die Verankerung und Durchsetzung der Rollen und einer starken Governance sind die Voraussetzung dafür, dass die verschiedenen Teams orchestriert zusammenarbeiten, qualitativ hochwertige Datenprodukte geliefert werden und der weitgehende Self-Service im Rahmen zuverlässiger Standards funktioniert.

Die Umsetzung von Data Mesh steht und fällt mit dem Reifegrad dieser Datenorganisation. Diese Organisation ist funktionsübergreifend und deckt sich damit nicht unbedingt mit der üblichen Einteilung in Geschäfts- oder Fachbereichen. Daher ist die Mitwirkung des Management Boards bei der Kontrolle und Etablierung der datengesteuerten Organisation und Architektur unbedingt notwendig.

Data Mesh setzt sich durch

Unternehmen verstehen, dass Daten immer mehr zur Wertschöpfung beitragen. Die kluge Nutzung und Auswertung der Daten bringen den entscheidenden Wettbewerbsvorteil. Für größere Konzerne und auch für viele mittelständische Unternehmen ist erweiterte Analytics daher inzwischen selbstverständlich. Data Mesh bietet die Möglichkeit, sich in diesem Bereich agiler aufzustellen.

QUNIS sieht daher derzeit eine große Dynamik und viel Kraft am Markt, das verteilte Organisations- und Architekturkonzept im Unternehmen umzusetzen. In den Projekten zeigt sich, dass das Data Lakehouse hierbei eine große Hilfe ist, weil die Technologie das flexible Splitten von Datenräumen erlaubt und die Verteilung von Verantwortung für Datenprodukte unterstützt.

Mein Tipp: Wenn Sie mehr über Data Mesh wissen wollen, folgen Sie uns auf LinkedIn und Xing oder abonnieren Sie einfach unseren Newsletter. Oder kontaktieren Sie uns und schreiben Sie mir direkt über KONTAKT ich freue mich über den Austausch mit Ihnen!