Data & Analytics (D & A) ist Grundlage für Controlling (Business Intelligence/BI) und geht weit darüber hinaus - sie ist integrale Kompetenz moderner Organisationen und zentraler Hebel im datengetriebenen Unternehmen. Als Rückgrat moderner Unternehmenssteuerung ermöglicht Data & Analytics datenbasierte Entscheidungen, überall dort, wo es darauf ankommt.

Datengetriebene Entscheidungen – in jedem Bereich

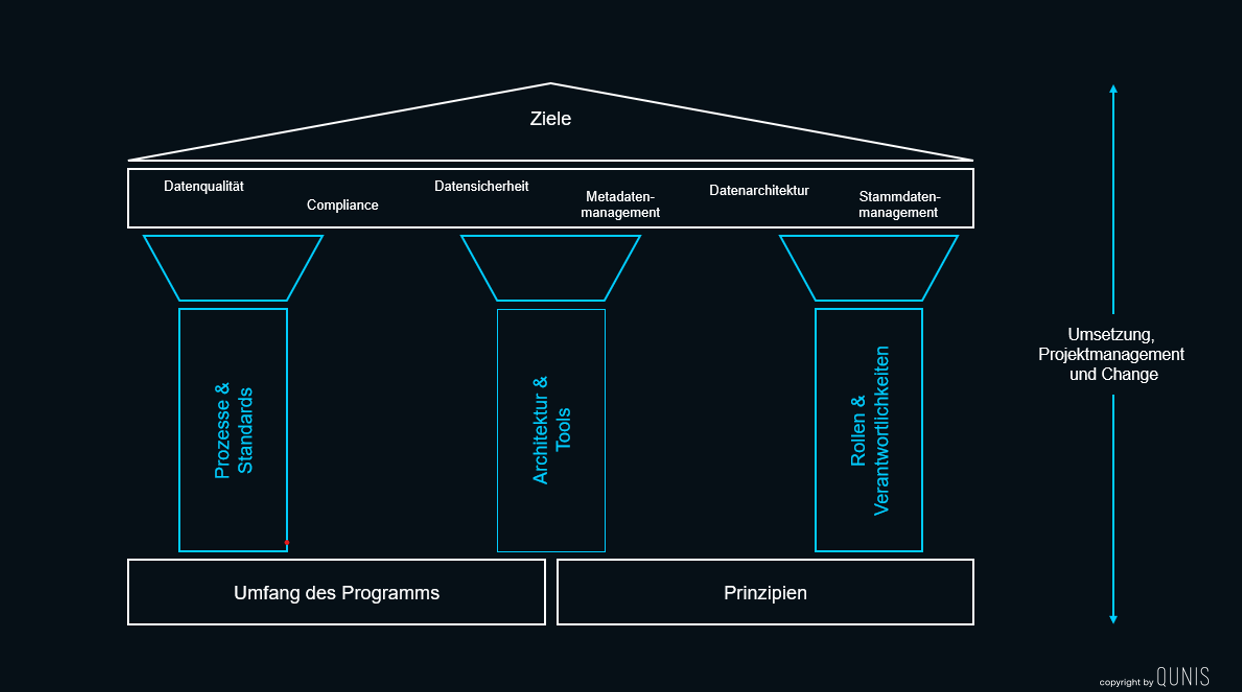

Daten durchdringen alle Unternehmensbereiche: von Finance über Vertrieb und Operations bis hin zu HR, Produktentwicklung, Produktion, Services. Wer fundiert entscheiden und zukunftsfähig bleiben will, braucht eine bewusste Datenstrategie, ein zentrales Datenmanagement und eine passende Datenplattform - direkt anschlussfähig an die übergeordneten Unternehmensziele. Wesentliche Data & Analytics-Bausteine sind eine skalierbare Datenarchitektur, samt passender Technologie für Visualisierung, Self Service und Metadatenmanagement sowie eine bewusste Organisation mit klaren Rollen, Zuständigkeiten, Governance und Betriebskonzept.